Hadoop安装

本教程是以Ubuntu 系统作为安装讲解环境,为了减少不必要的麻烦,请您 安装Ubuntu 并能正常启动进入系统。同时也必须要 安装Java。

一、添加 Hadoop 系统用户组和用户

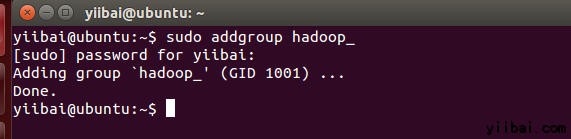

使用以下命令在终端中执行以下命令来先创建一个用户组:yiibai@ubuntu:~$ sudo addgroup hadoop_操作结果如下:

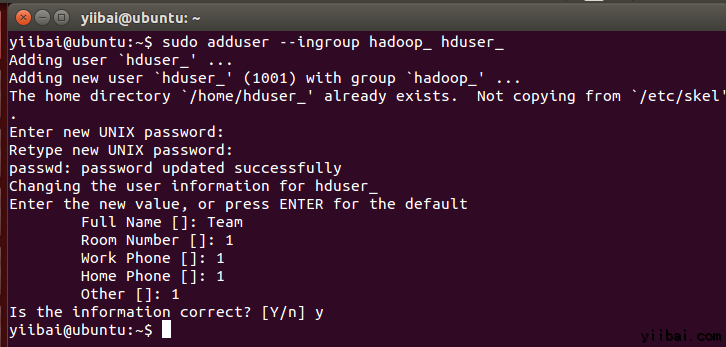

使用以下命令来添加用户:

yiibai@ubuntu:~$ sudo adduser --ingroup hadoop_ hduser_

输入您的密码,姓名和其他详细信息。

二、配置SSH

为了在集群管理节点,Hadoop需要SSH访问

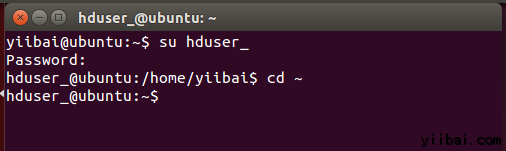

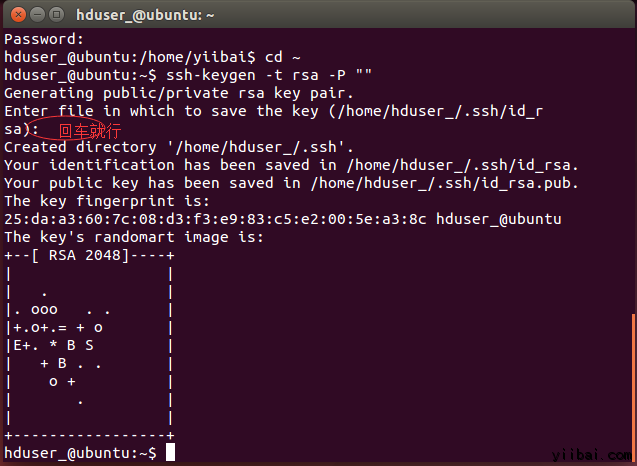

首先,切换用户,输入以下命令:

yiibai@ubuntu:~$ su hduser_

hduser_@ubuntu:~$ ssh-keygen -t rsa -P ""

使用此密钥启用SSH访问本地计算机。

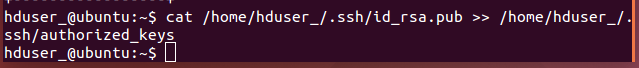

hduser_@ubuntu:~$ cat /home/hduser_/.ssd/id_rsa.pub >> /home/hduser_/.ssh/authorized_keys

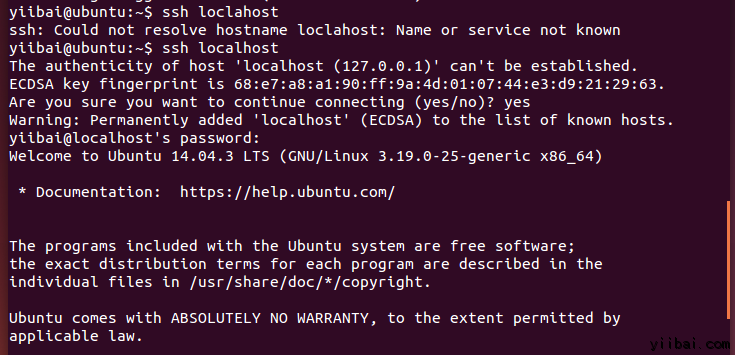

现在,测试SSH设置通过“hduser”用户连接到locahost。

hduser_@ubuntu:~$ ssh localhost

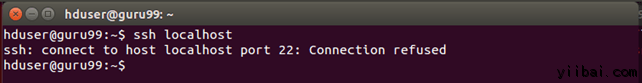

注意:

请注意,执行 'ssh localhost' 命令后如果看到下面的错误响应, 可能 SSH 在此系统不可用。

来解决上面这个问题,安装 SSH 服务 -

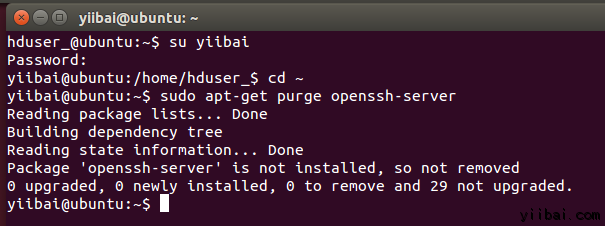

清除 SSH 使用以下命令:

hduser_@ubuntu:~$ sudo apt-get purge openssh-server

在安装开始前清除 SSH 服务,这是一个很好的做法(建议),如果遇到“

yiibai@ubuntu:~$ sudo apt-get install openssh-server

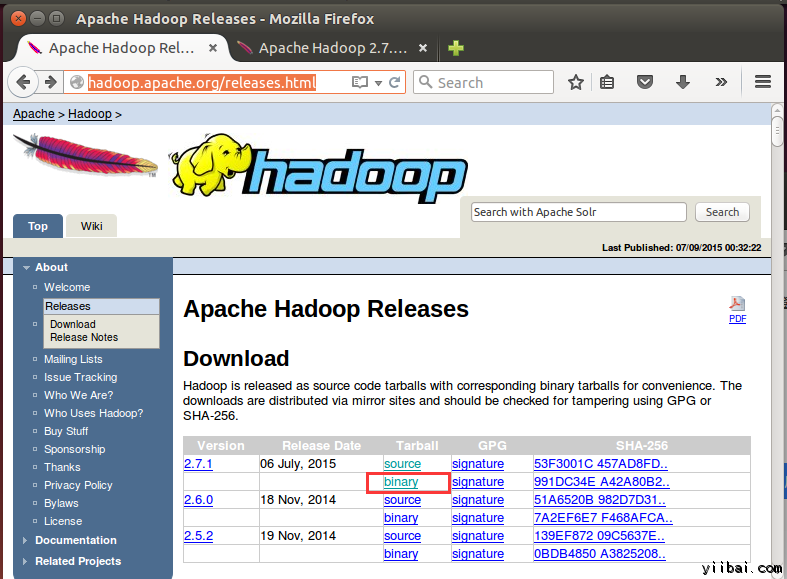

三、下载Hadoop

在浏览器中打开网址:http://hadoop.apache.org/releases.html

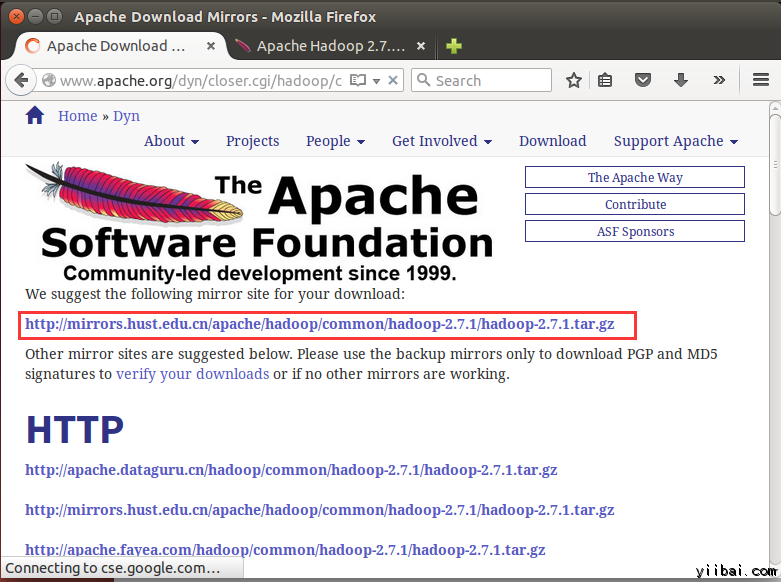

选择一个最新 2.7.1 的稳定版本(stable)的二进制包下载,如下:

yiibai@ubuntu:~$ cd /home/yiibai/Downloads使用以下命令解压文件包:

yiibai@ubuntu:~$ sudo tar xzf hadoop-2.7.1.tar.gz

yiibai@ubuntu:~$ sudo mv hadoop-2.7.1 /usr/local/hadoop更改文件用户属性,执行以下命令:

yiibai@ubuntu:~$ cd /usr/local yiibai@ubuntu:~$ sudo chown -R hduser_:hadoop_ hadoop

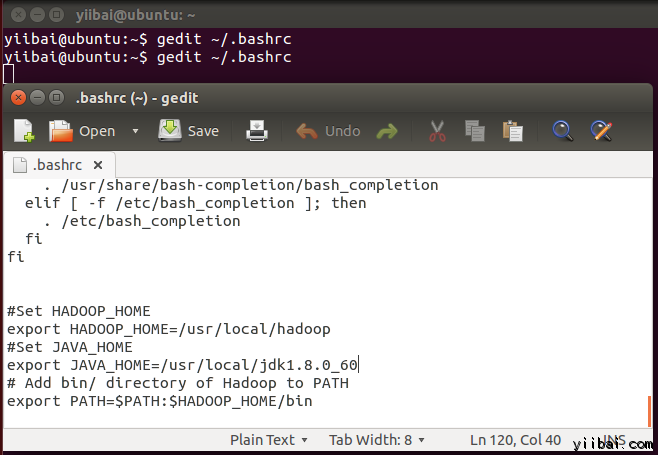

四、修改 ~/.bashrc 文件

添加以下这些行到 ~/.bashrc 文件的末尾,内容如下所示:

|

1

2

3

4

5

6

|

#Set HADOOP_HOME

export HADOOP_HOME=/usr/local/hadoop

#Set JAVA_HOME

export JAVA_HOME=/usr/local/jdk1.8.0_60

# Add bin/ directory of Hadoop to PATH

export PATH=$PATH:$HADOOP_HOME/bin

|

在终端下执行以下命令,打开编辑器并将上面的内容加入到文件的底部,如下图所示:

yiibai@ubuntu:~$ vi ~/.bashrc

现在,使用下面的命令环境配置

yiibai@ubuntu:~$ . ~/.bashrc

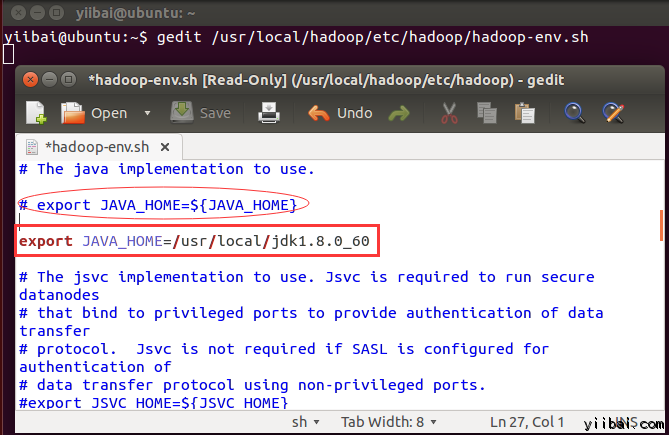

五、配置关联HDFS

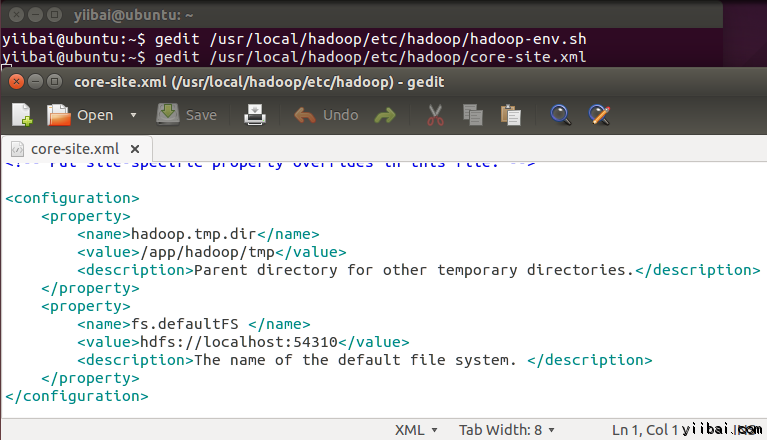

在 $HADOOP_HOME/etc/hadoop/core-site.xml 文件中还有两个参数需要设置:

1. 'hadoop.tmp.dir' - 用于指定目录让 Hadoop 来存储其数据文件。

2. 'fs.default.name' - 指定默认的文件系统

为了设置两个参数,打开文件 core-site.xml

yiibai@ubuntu:~$ sudo gedit /usr/local/hadoop/etc/hadoop/core-site.xml拷贝以下所有行的内容放入到标签 <configuration></configuration> 中间。

|

1

2

3

4

5

6

7

8

9

10

|

<property>

<name>hadoop.tmp.dir</name>

<value>/app/hadoop/tmp</value>

<description>Parent directory for other temporary directories.</description>

</property>

<property>

<name>fs.defaultFS </name>

<value>hdfs://localhost:54310</value>

<description>The name of the default file system. </description>

</property>

|

yiibai@ubuntu:~$ cd /usr/local/hadoop/etc/hadoop yiibai@ubuntu:/usr/local/hadoop/etc/hadoop$

现在创建一个目录,如上面配置 core-site.xml 中使用的目录:/app/hadoop/tmp

yiibai@ubuntu:/usr/local/hadoop/etc/hadoop$ sudo mkdir -p /app/hadoop/tmp

授予权限目录 /app/hadoop/tmp,执行如下的命令:

yiibai@ubuntu:~$ sudo chown -R hduser_:hadoop_ /app/hadoop/tmp yiibai@ubuntu:~$ sudo chmod 750 /app/hadoop/tmp

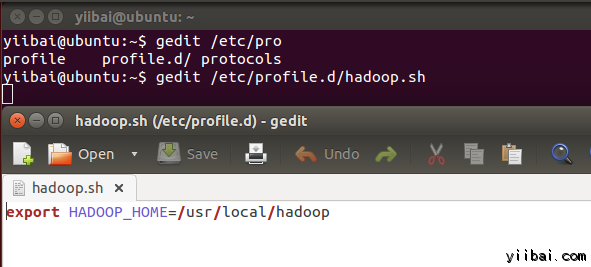

yiibai@ubuntu:~$ sudo gedit /etc/profile.d/hadoop.sh

然后输入以下一行,

export HADOOP_HOME=/usr/local/hadoop

再执行以下命令:

yiibai@ubuntu:~$ sudo chmod +x /etc/profile.d/hadoop.sh

yiibai@ubuntu:~$ echo $HADOOP_HOME /usr/local/hadoop

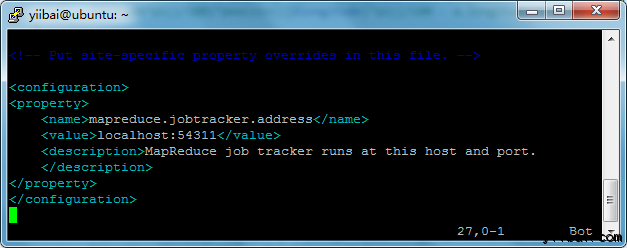

现在复制文件,执行以下命令:

yiibai@ubuntu:~$ sudo cp $HADOOP_HOME/etc/hadoop/mapred-site.xml.template $HADOOP_HOME/etc/hadoop/mapred-site.xml

yiibai@ubuntu:~$ sudo vi $HADOOP_HOME/etc/hadoop/mapred-site.xml

|

1

2

3

4

5

6

|

<property>

<name>mapreduce.jobtracker.address</name>

<value>localhost:54311</value>

<description>MapReduce job tracker runs at this host and port.

</description>

</property>

|

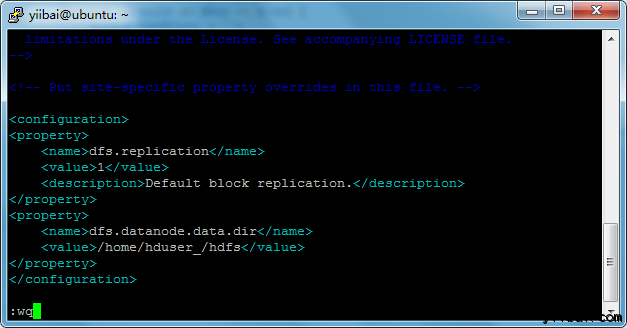

yiibai@ubuntu:~$ sudo vi $HADOOP_HOME/etc/hadoop/hdfs-site.xml

添加以下的设置内容到标签<configuration> 和 </configuration> 中,如下图所示:

|

1

2

3

4

5

6

7

8

9

|

<property>

<name>dfs.replication</name>

<value>1</value>

<description>Default block replication.</description>

</property>

<property>

<name>dfs.datanode.data.dir</name>

<value>/home/hduser_/hdfs</value>

</property>

|

yiibai@ubuntu:~$ sudo mkdir -p /home/hduser_/hdfs yiibai@ubuntu:~$ sudo chown -R hduser_:hadoop_ /home/hduser_/hdfs yiibai@ubuntu:~$ sudo chmod 750 /home/hduser_/hdfs

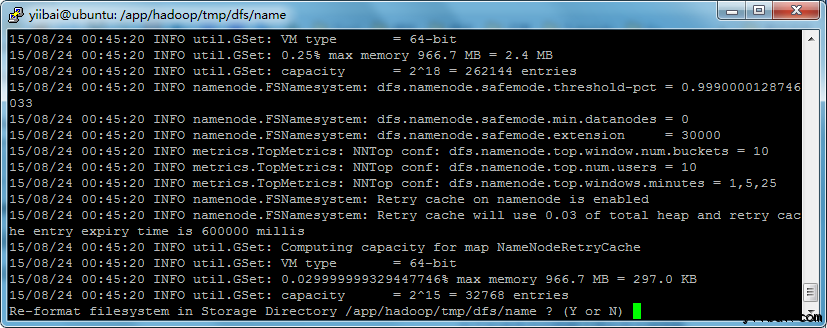

七、格式化HDFS

yiibai@ubuntu:~$ $HADOOP_HOME/bin/hdfs namenode -format

yiibai@ubuntu:~$ sudo mkdir -p /app/hadoop/tmp/dfs/name/current yiibai@ubuntu:~$ sudo chmod -R a+w /app/hadoop/tmp/dfs/name/current/

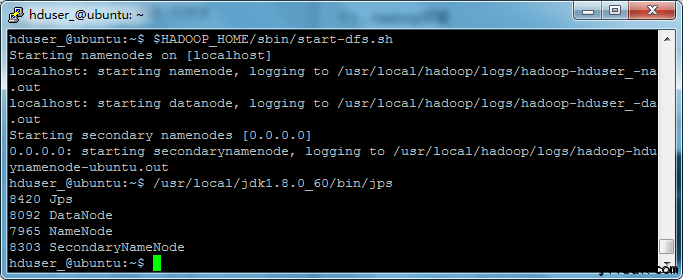

八、 启动 Hadoop 的单节点集群

使用以下命令启动cHadoop 的单节点集群(使用 hduser_ 用户来启动),如下:

hduser_@ubuntu:~$ $HADOOP_HOME/sbin/start-dfs.sh

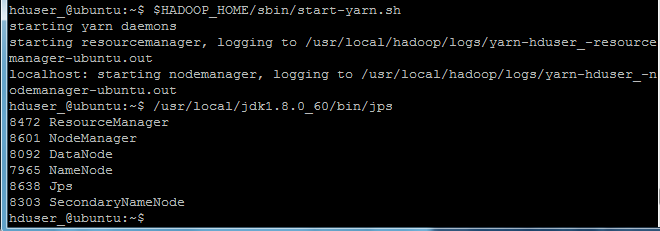

hduser_@ubuntu:~$ $HADOOP_HOME/sbin/start-yarn.sh

hduser_@ubuntu:~$ /usr/local/jdk1.8.0_60/bin/jps

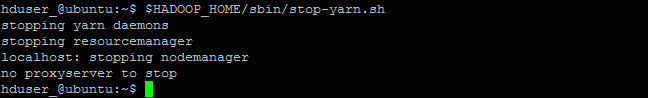

hduser_@ubuntu:~$ $HADOOP_HOME/sbin/stop-dfs.sh

hduser_@ubuntu:~$ $HADOOP_HOME/sbin/stop-yarn.sh

the end.

欢迎任何形式的转载,但请务必注明出处,尊重他人劳动共创优秀实例教程

转载请注明:文章转载自:代码驿站 [http:/www.codeinn.net]

本文标题:Hadoop安装

本文地址:http://www.codeinn.net/hadoop/5.html